在AI时代,数据是燃料,但原始的非结构化数据——文本、图像、音频——对机器而言如同天书。数据向量化正是破解这道屏障的核心技术,它将人类语言、视觉和声音转化为机器可理解的数学语言。如果说向量数据库是AI的“记忆中枢”,那么向量化就是为它提供标准化记忆单元的“翻译引擎”。

一、为什么需要数据向量化?

传统计算机只能处理数值,而人类数据是多元且模糊的。例如:

语义鸿沟:搜索“续航久的手机”,传统关键词匹配可能遗漏“电池耐用”的描述;

模态差异:用文字描述一幅画(如“星空下的旋转木马”),无法直接匹配图像;

特征隐藏:一段音频中的情绪(愤怒vs平静)无法通过波形直接识别。

向量化通过高维向量(如512维数组)捕捉数据的语义或特征本质,让机器理解“续航久”与“电池耐用”的关联,或从音频波形中识别愤怒的声纹模式。

二、四大数据类型向量化实战

1. 文本向量化:从词袋到语义地图

基础方法

One-Hot编码:将每个词转化为唯一二进制向量(如“苹果”=[1,0,0]),简单但无法表达语义关联。

TF-IDF:统计词频与重要性,适合关键词提取,但仍忽略上下文。

进阶:词嵌入(Embedding)

Word2Vec:通过预测相邻词学习向量,使语义相近词(如“国王”与“王后”)向量空间距离接近。

BERT:基于Transformer的上下文建模,同一词在不同语境(如“苹果公司”vs“苹果水果”)有不同向量。

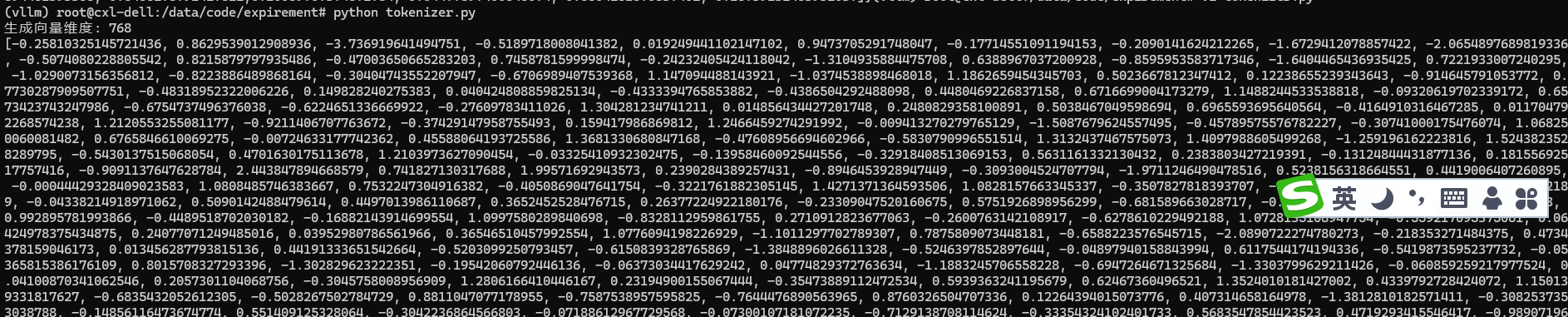

代码片段(使用 Ollama 模型向量化):

import requests import json def get_embedding(text, model="nomic-embed-text"): url = "http://localhost:11434/api/embeddings" headers = {"Content-Type": "application/json"} data = {"model": model, "prompt": text} # Ollama API 要求使用 "prompt" 字段 response = requests.post(url, headers=headers, data=json.dumps(data)) if response.status_code == 200: return response.json()["embedding"] else: raise Exception(f"向量化失败: {response.text}") # 示例:将中文文本转为向量 text = "天空之因为是蓝色的除了是因为太阳之外还有因为我呀!" embedding = get_embedding(text) print(f"生成向量维度: {len(embedding)}") # nomic-embed-text 输出 8192 维向量 print(embedding)

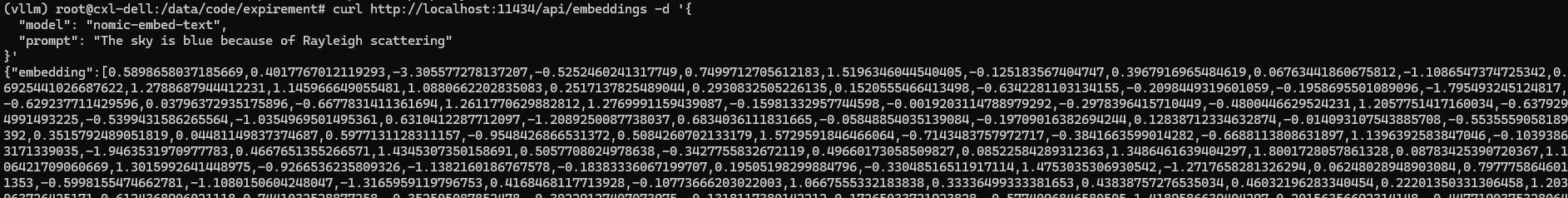

或直接使用 url 请求 Ollama 模型向量化:

或直接使用 url 请求 Ollama 模型向量化:

curl http://localhost:11434/api/embeddings -d '{ "model": "nomic-embed-text", "prompt": "天空之因为是蓝色的主要是因为太阳呀!"}'

应用场景

语义搜索:将用户查询与文档库向量匹配,超越关键词匹配

情感分析:向量聚类判断评论正负面(如差评聚集在向量空间负象限)

2. 图像向量化:从像素到特征指纹

传统方法

像素展开:将图片像素矩阵拉平为一维向量(如224x224图片→50176维),保留全部信息但冗余严重。

深度学习革命

CNN特征提取:使用预训练ResNet、VGG等模型,通过卷积层提取边缘、纹理等特征,输出紧凑向量(如ResNet-50输出2048维)。

工具推荐:PyTorch的torchvision.models或TensorFlow Hub的预训练模型库。

多模态突破

CLIP模型:联合训练图像与文本,使向量空间对齐——搜索“憨态可掬的熊猫”直接返回相关图片。

3. 音频向量化:从声波到情绪标签

声学特征提取

MFCC(梅尔频率倒谱系数):模拟人耳听觉特性,将声波转化为频域特征向量,广泛用于语音识别。

频谱图:将声音时频信息转为图像,再通过CNN向量化(如识别玻璃破碎声)。

端到端学习

Wav2Vec 2.0:直接从未标注音频学习向量,支持低资源语言识别。

应用案例:智能客服:根据用户语音向量判断情绪(愤怒→高音调、快语速向量特征),转接人工客服

4. 时间序列向量化:从波动到规律

滑动窗口统计:计算窗口内均值、方差等特征,捕捉局部模式(如股票30天波动趋势)。

RNN/LSTM编码:循环网络处理序列依赖,输出表征整体动态的向量(如预测设备故障)。

Transformer时序模型:如Informer,处理长序列依赖,适用于能源消耗预测。

三、向量化技术选型指南

四、避坑指南:向量化常见陷阱

维度灾难

高维向量(>1000维)易导致计算效率下降。解法:使用PCA或t-SNE降维;

选择紧凑模型(如MobileNet替代ResNet)。

语义失真

同一词在不同领域含义不同(如“Java”指编程语言或咖啡)。解法:领域自适应训练(在医疗文本上微调BERT);

多模态对齐偏差

图文向量空间未对齐导致搜索“红色跑车”返回番茄图片。解法:使用对比学习(如CLIP)强制跨模态向量相似。

五、未来趋势:向量化的下一站

无监督向量化:

DALL·E 3等模型无需标注数据,直接从原始数据学习通用向量表示;实时向量生成:

边缘设备(如手机)本地运行微型模型,即时生成用户行为向量;可解释向量:

可视化工具(如Embedding Projector)解码向量维度含义,提升AI透明度。

结语:数据翻译官,AI的基石

向量化不仅是技术,更是连接人类认知与机器智能的桥梁。当文本化作语义地图,图像转为特征指纹,声音变成频率图谱——世界的数据洪流终于成为机器可理解的河流。而这条河流的尽头,正是向量数据库中等待被唤醒的智能宇宙。

正如语言学家萨尔尔所说:“人类文明的边界由语言划定。” 在AI文明中,向量化正在重塑这条边界,让机器真正读懂世界📖。